Transformation von Testorganisationen

Interview mit Thomas Winkeler, Senior Managing Consulting – IBM Deutschland Application Management Services Sales, Lead Testing

Innovative Verfahren, moderne Technologien und Tools spielen bei der Transfomation von Testorganisationen eine entscheidende Rolle, um signifikante Kostensenkungen zu realisieren, Qualitätsverbesserungen zu erreichen, Testdurchlaufzeiten zu verkürzen und gleichzeitig die geschäftlichen Risiken zu minimieren. IBM ist durch die Kombination von IBM Testing Services mit übergreifenden Lösungen von IBM Rational Software für Qualitätssicherung und Testautomatisierung und den Erkenntnissen aus IBM Research in der Lage, die neuesten Anforderungen im Bereich Testen von Software umzusetzen.

eD: Herr Winkeler, Sie sagen der Testmarkt unterliege einem Transformationsprozess. Wie sieht dieser Prozess aus und welches sind die wesentlichen Ursachen dieses Wandels?

Thomas Winkeler: In der Vergangenheit wurde das Testen von Anwendungen vielfach als notwendiges, aber wenig nutzbringendes Anhängsel klassischer Software-Entwicklungsprojekte gesehen. Diese Betrachtungsweise hat sich nicht zuletzt vor dem Hintergrund geändert, dass Testen, über den Lebenszyklus einer Applikation betrachtet, zwischen 25 und 50% der anfallenden Gesamtkosten in Anspruch nimmt. Auch Software-Qualitätsprobleme können schwerwiegende Konsequenzen nach sich ziehen, wie beispielsweise eine qualitätsbedingte Projektverzögerung, die oftmals die Time-to-Market verlängert. Größte kommerzielle und materielle Schäden können entstehen, wenn beispielsweise eine Buchungsplattform aus softwaretechnischen Gründen ausfällt, wichtige Daten verloren gehen bzw. verfälscht werden oder Sicherheitslücken im System zum Diebstahl von Kunden- oder Kreditkarteninformationen führen. Darüber hinaus steigen durch die immer engere Verzahnung von Business und IT die Anforderungen an Time-to-Market und Qualität, was den Leistungsdruck auf die Testorganisationen erhöht. Zugleich werden die Systeme und IT-Landschaften immer komplexer und die Software-Entwicklungs- und -Lebenszyklen schneller. Hinzu kommen erweiterte regulatorische und sicherheitsspezifische Anforderungen. Insofern ist es nur konsequent, dass seit einigen Jahren das Testen von Anwendungen zu den aktuellen Fokusthemen der IT zählt.

eD: Wie muss sich das Testen konzeptionell verändern und weiterentwickeln, um diesen gestiegenen Anforderungen an die Professionalisierung beim Testen von Geschäftsentwicklungen zu begegnen?

Thomas Winkeler: Der Leitgedanke ‚Next Generation Testing‘ von IBM umfasst den gesamten Testlebenszyklus einer Applikation und adressiert vier Ziele: Kostensenkung, Qualitätsverbesserung, Risikomanagement und Optimierung der Testdurchlaufzeiten. Werden diese vier Ziele nicht in ihrer Gesamtheit berücksichtigt, ergibt sich ein verzerrter Blick auf den Beitrag, den das moderne Testen leisten kann. Im Mittelpunkt von ‚Next Generation Testing‘ stehen dabei Daten. Daten werden gefiltert und analysiert, um daraus detaillierte und verwertbare Informationen zu erhalten. So können beispielsweise durch die Analyse der Datenbasis von Softwarefehlern Rückschlüsse auf strukturelle Probleme im Entwicklungsprozess gezogen werden. Dabei hilft eine empirisch untermauerte Kenntnis über eine prognostizierte Fehlerverteilung, den Testprozess effizienter zu managen. Diese und weitere Informationen dienen als Basis zur Ableitung intelligenter Handlungsalternativen und Maßnahmen, die im Ergebnis zum Einsatz neuer Servicemodelle, Tools und Methoden führen.

eD: Welche Servicekonzepte, Tools und Methoden gibt es zum Professionalisieren des Testens?

Thomas Winkeler: Die Professionalisierung des Testens geht mit einer Transformation der heutigen Organisation einher. Dabei kommen neue Servicekonzepte, häufig in Form von sogenannten ‚Test-Factory-Modellen‘, zur Anwendung. Aus dem Testportfolio der Kundenorganisation werden exakt definierte Bereiche ‚herausgeschnitten‘ und dann in Form eines industrialisierten ‚Managed-Service-Modells‘ umgesetzt. Die Ausgestaltung der ‚Test-Factory-Services‘ sind je nach den individuellen Kundenwünschen vielfältig: Breite der Testverfahren, Skalierbarkeit der Testvolumina, flexible Testinhalte und Abrechnungsmodelle auf Testfallbasis kennzeichnen diese Lösungsmodelle. Darüber hinaus zählen auf den Kundenwunsch zugeschnittene Service-Level-Vereinbarungen zu den wichtigen Bausteinen einer Test-Factory-Implementierung.

eD: Was sollte im Vordergrund der Betrachtung alternativer Szenarien stehen?

Thomas Winkeler: Gleichgültig welches Servicemodell letztendlich zum Einsatz kommt, sollte im Vordergrund der Betrachtungen alternativer Szenarien immer die integrierte Sicht auf Kostensenkung, Qualitätsverbesserung, Risikominimierung und die Optimierung der Testdurchlaufzeiten stehen. Die moderne Testberatung muss den Einsatz neuer, innovativer Technologien, Methoden und Tools vor dem Hintergrund einer Kosten-Nutzen-Analyse in die Betrachtung einbeziehen. Die Erfahrung hat gezeigt, dass hier häufig sehr schnelle Erfolge erzielt werden können.

eD: Welche innovativen Test-Technologien gibt es und was macht sie so innovativ?

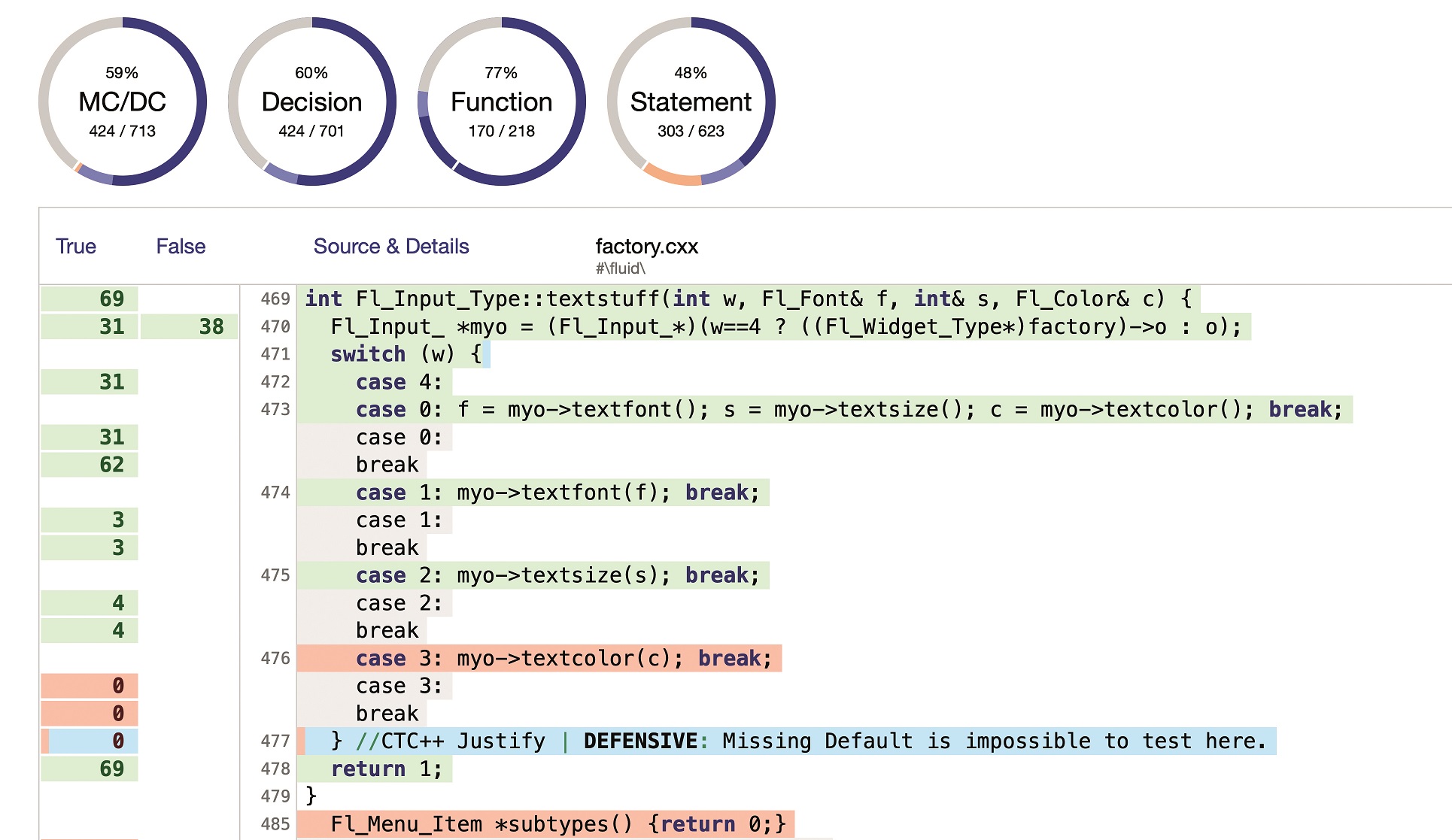

Thomas Winkeler: Die IBM ‚Testplanning and Optimization Workbench (TPOW)‘ beispielsweise unterstützt eine ‚risikobasierte‘ Testplanung unter expliziter Einbindung empirischer Daten. Eine im Rahmen von TPOW durchgeführte detaillierte Fehleranalyse hilft, systematische Fehlerursachen aufzuzeigen und zu beseitigen. Die Analyse nutzt dabei eine Fülle empirischer Testdaten aus vorangegangenen Testprojekten. Damit können unter anderem Schwächen in wichtigen Risiko- und Qualitätsbereichen proaktiv ermittelt werden. TPOW liefert dem Anwender eine optimierte Teststrategie unter Berücksichtigung alternativer, unter Risikogesichtspunkten bewerteter Handlungsempfehlungen, einen dazugehörigen Test-Master-Plan sowie den detaillierten Testprojektplan. Die Kunden profitieren von Kosteneinsparungen, einer schnelleren Time-to-Market und einem deutlich gestiegenen Qualitätsniveau. Ein weiteres Beispiel ist das Konzept der Applikationsvirtualisierung, basierend auf dem Einsatz spezifischer Software. Diese innovative Test-Technologie beseitigt kritische Zugangs- und Kapazitätsengpässe, die beim Testen in heterogenen Umgebungen sehr häufig ein kostspieliges und zeitraubendes Hindernis sind. Die kritische und für den Integrationstest benötigte Zulieferapplikation wird mittels einer zwischengeschalteten Anwendung simuliert. Der Test kann so unabhängig von der ‚echten‘ Applikation durchgeführt werden. Im Bereich Testinfrastruktur ist außerdem Cloud-Testing ein wichtiges Stichwort. Wer über Cloud-basierte Testinfrastrukturen nachdenkt, sieht sich automatisch mit dem Thema ‚Sensibiltät der eigenen Testdaten‘ und dem damit verbundenen Testdatenmanagement konfrontiert.

eD: Wo werden testspezifische Informationen in einer gut funktionierenden Testorganisation gebündelt?

Thomas Winkeler: Für das prozessübergreifende Management sämtlicher Testaktivitäten zeichnet sich die kollaborative Testplattform verantwortlich, so z.B. die ‚IBM-Rational Software‘. Die Testaktivitäten umfassen Aufgaben, Arbeitsergebnisse sowie die beteiligten Personen unter Berücksichtigung der individuellen Rollen- und Verantwortlichkeitsbeschreibung. Angrenzende Prozesse wie Anforderungs- und Projektmanagement sowie Softwareerstellung und -deployment müssen hierbei in den Gesamtprozess integriert werden. Unter Verwendung der ‚Jazz Plattform‘ von IBM kann ein solch übergreifender Ansatz realisiert werden. Kerntestaktivitäten wie Testplanung, Testautomatisierung und Testausführung können dabei in engem Zusammenspiel mit dem Anforderungsmanagement, der Entwicklung und der Projektplanung stattfinden. Dabei stehen Aspekte wie Kollaboration, Automatisierung und Transparenz im Vordergrund. Eine wichtige Anforderung an die Kollaborationsplattform ist die Nachvollziehbarkeit und Verfolgbarkeit von Änderungen, Aufgaben und Arbeitsergebnissen. Durch neue oder geänderte Anforderungen erfolgt eine ständige Anpassung von Spezifikationen, wie z.B. Dokumenten- Modell-, Quellcode- oder Testbeschreibungen. Diese voneinander abhängigen Informationen müssen aufeinander abgestimmt werden, was ohne Werkzeuge und Integrationen nicht gewährleistet werden kann.

eD: Welches ist die elementare Komponente der IBM-Rational Testsoftware?

Thomas Winkeler: Die elementare Komponente ist der ‚IBM Quality Manager‘. Eine Web 2.0 basierte Oberfläche ermöglicht die teamübergreifende Durchführung des kompletten Testprozesses von der Planung über die Ausführung bis hin zur Auswertung der Testergebnisse. Mit ‚IBM Rational Quality Manager‘ können verschiedenste Testverfahren implementiert werden. Neben dem im Werkzeug selbst vorhandenen manuellen Testeditor, mit dem interaktive Testskripte erstellt und ausgeführt werden können, existieren offene Schnittstellen und Adapter für verschiedene Testautomatisierungswerkzeuge von IBM oder anderen Herstellern. Diese Offenheit bietet Investitionssicherheit, da bereits vorhandene Testautomatisierungswerkzeuge integriert und weiter genutzt werden können. Für den Zugriff auf Informationen des ‚Rational Quality Manager‘ bietet das Werkzeug ‚Representational State Transfer (REST)‘ basierte Schnittstellen an. Die REST-Services stellen einen plattformunabhängigen und leichtgewichtigen Architekturstil dar, mit dem Ressourcen einfach über http und XML adressiert und verändert werden können. So lässt sich jede Ressource über eine URL eindeutig identifizieren. Wie alle Jazz-basierten Werkzeuge nutzt der ‚IBM Rational Quality Manager‘ die ‚Open Services for Lifecycle Collaboration (OSLC)‘ Spezifikation. Darunter versteht man einen herstellerübergreifenden Standard für die domänenübergreifende Kommunikation von Tools unterschiedlicher Hersteller im Application-Lifecycle-Management, dessen Spezifikation ebenfalls auf Rest Services beruht. Der Anwender kann damit Artefakte unterschiedlicher Werkzeuge und Hersteller über Verlinkungen semantisch miteinander verbinden.