In der Wirklichkeitsfabrik

Hinter immersiver Virtual Reality steckt Hard- und Software, die Unglaubliches leistet. Worauf es ankommt und warum ohne Smartphones nichts funktioniert, erklärt Hamid-Reza Nazeman von Qualcomm.

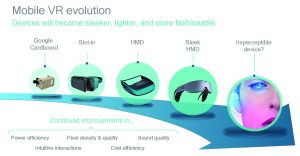

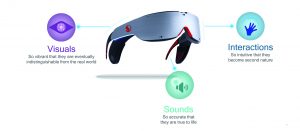

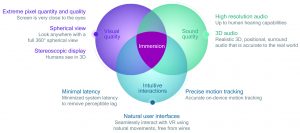

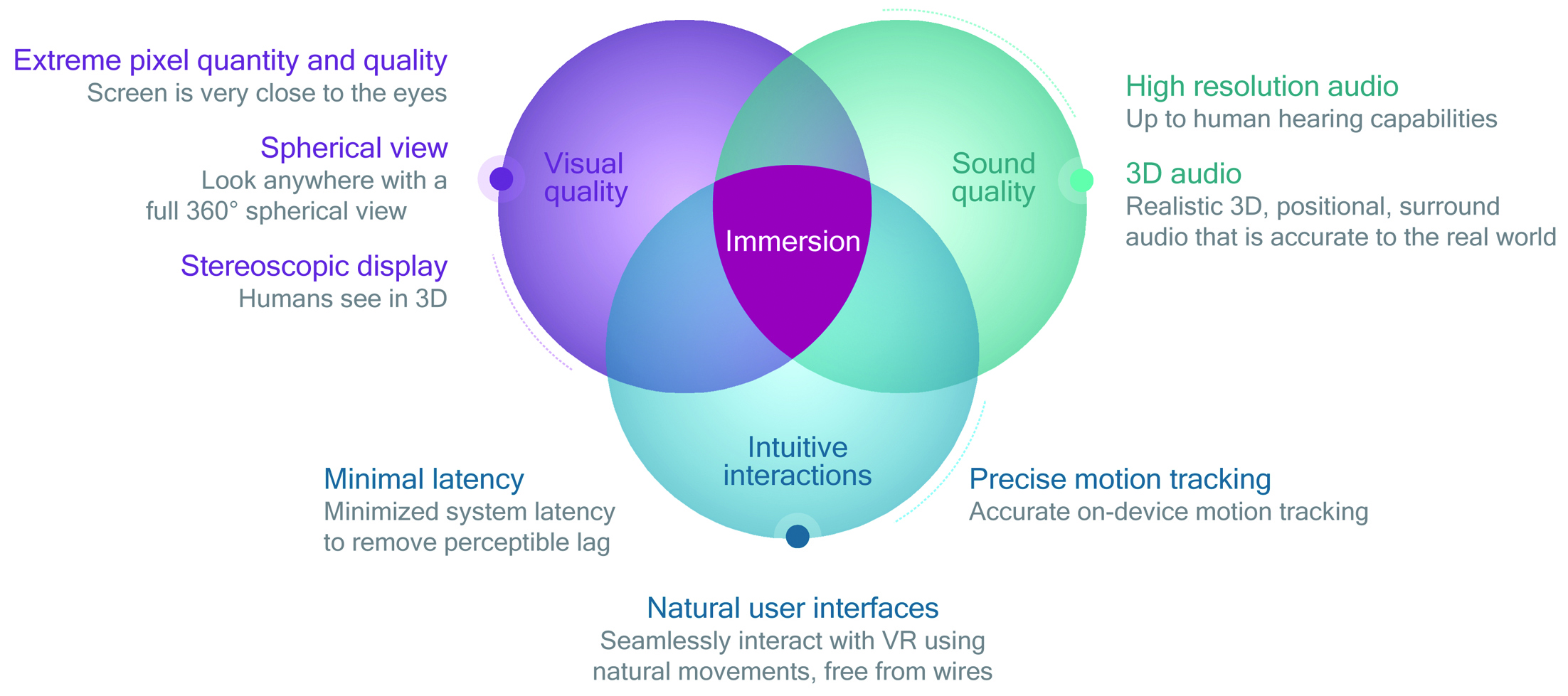

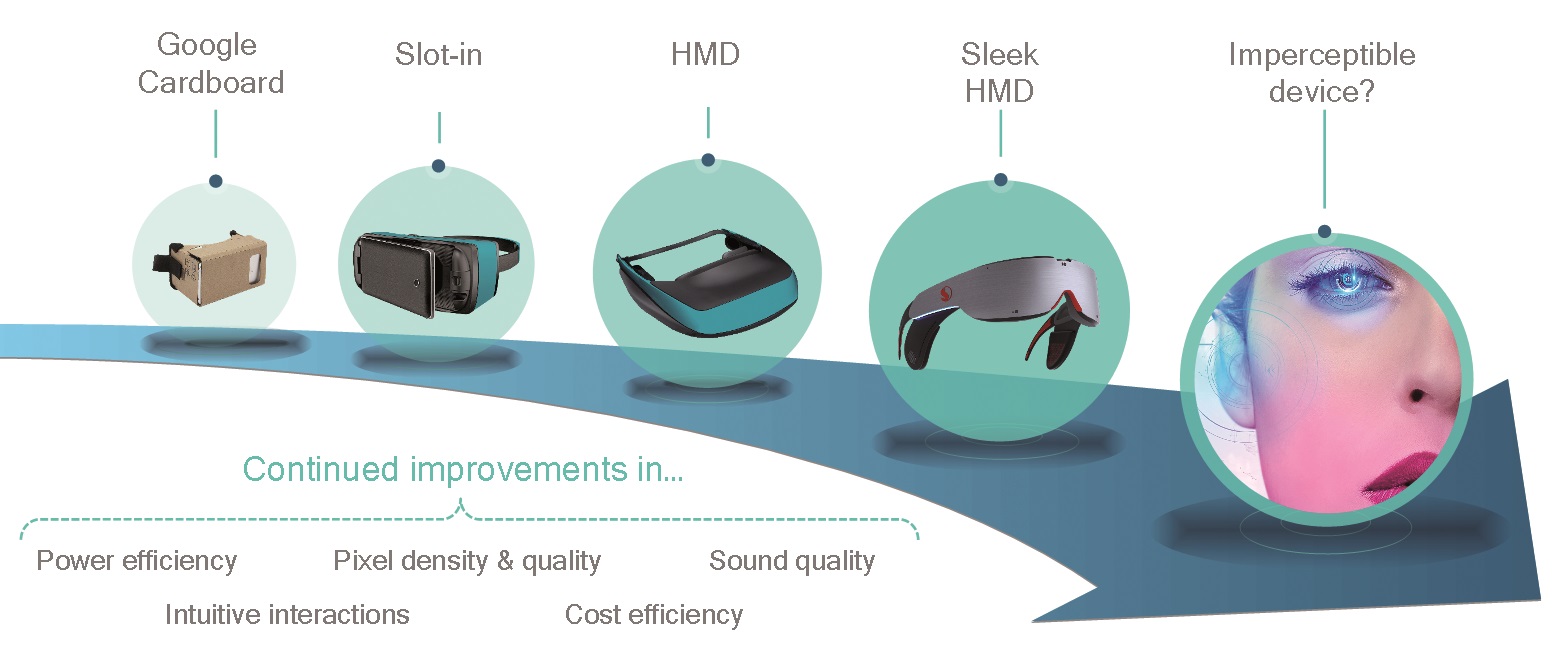

Wenn wir ganz im Moment aufgehen – das nennen wir Immersion. Wir lassen uns an fiktive Orte transportieren und halten das für real. Die ultimative Immersion werden wir bald serienmäßig erleben: Virtual Reality. Dafür müssen drei Faktoren zusammenkommen: Fotorealistische Grafik, 3D-Sound und ein Interface, das dem Nutzer in Fleisch und Blut übergeht. Zurzeit erleben wir das Zusammentreffen zweier Entwicklungsstränge, die gemeinsam das Zeitalter der VR einläuten: das richtige VR-Ökosystem und die notwendigen technischen Entwicklungen. Zum Ökosystem gehören Devices (wie Samsung Gear VR, Google Pixel), Softwareinfrastruktur (Treiber, Betriebssystem, Middleware-Engines, Tools und SDKs) und die Verfügbarkeit und kreative Produktion von Content – Google Play Store, Oculus Store oder Youtube 360. In der Technik machen exponentielle Entwicklungen VR endlich möglich: Multimediatechnologien wie verbesserte Grafik-, Video- und Audio-Verarbeitung sind heute massentauglich, dazu Displays mit höchster Pixeldichte und Energieeffizienz, sowie Sensortechnologie wie Gyroskope, Beschleunigungsmesser und Kamera-Tracking mit kleineren, günstigeren und präziseren Teilen. Auch der Umgang mit Energie macht einen großen Teil des VR-Erfolges aus: Architekturinnovationen wie heterogenes Computing haben den Energie- und Wärmewirkungsgrad auf ein neues Level gehoben. Die Integrationseffizienz lässt nicht nach und so erhalten wir regelmäßig noch bessere Transistoren. Zuletzt spielen auch optimierte Algorithmen, etwa zur Bewegungserkennung, eine nicht zu verachtende Rolle in der technischen Entwicklung praktikabler VR-Lösungen.

Mobilfunk als Treiber von VR

Viele der genannten Fortschritte sind dem Smartphone zu verdanken. Die Mobilgeräte-Industrie wird daher für VR fürs erste der technische Maßstab bleiben, denn dort herrscht eine Atmosphäre, die neue Technologien schnell verbreitet. Innovation at Scale bedeutet Hochtechnologie mit Kostenvorteilen: In diesem Jahr werden mehr als eine Milliarde Smartphones ausgeliefert. Schnelle Designzyklen sind hier ebenso Usus wie Massenadoption – die Nutzung von Smartphones bereitet eine große Menge an Nutzern auf neue Entwicklungen vor, auf Grundlagen, die sie bereits kennen. Wie man eine App herunterlädt, weiß heute jedes Kind. Einen Haken hat VR jedoch: Wirklich immersiv wird es erst dann, wenn alle drei Felder Grafik, Sound und Interaktion enorme Leistung liefern – in verschiedenen Dimensionen. Hinzu kommt, dass Mobile VR volle Immersion mit minimalem Energieverbrauch und Wärmeausstoß leisten soll; so erst können VR-Headsets auch einen Massenmarkt erobern, in dem sich nicht jeder Benutzer eine Tonne vor das Gesicht schnallen möchte.

Grafik

Echte fotorealistische Grafik setzt enorme Pixeldichte und -qualität voraus. Das gesamte Sichtfeld muss sich in der virtuellen Welt befinden – mit einer sphärischen 360°-Sicht, was noch mehr Pixel erfordert. Eine spezielle Rendering-Methode, das Fovea-Rendering, kann dabei helfen. Die Fovea ist ein Teil des menschlichen Auges und für die zentrale Sehschärfe zuständig. Der Trick ist, dass in der menschlichen Optik die Schärfe in der Peripherie schnell abnimmt. Nutzt man diesen Effekt, so muss auch das virtuelle Auge nur einen Teil der Pixel rendern. Da der Nutzer sich mit VR-Headset frei um 360° drehen können will, muss das Gerät verschiedene sphärische 360°-Videoformate unterstützen. Um das Video abzuspielen, muss es eine Engine dekodieren. Je nach Format wählt die GPU die passende UV-Projektion – etwa als Plattkarte (Rektangularprojektion) oder Cube Mapping. Abhängig von der Position des Kopfes bekommt dann jedes Auge das entsprechende Stück des 360°-Videos zu sehen.

Sound

Hochauflösender Ton setzt eine hohe Abtastrate sowie hohe Bitzahlen pro Sample voraus. Realistischer 3D-Ton oder Positional Audio erfordert dynamische Anpassungen an die Bewegung des Nutzers. So entsteht nicht nur 3D-Surround-Sound, sondern ein Ton, der sich je nach Position der Geräuschquelle und des Zuhörers verändert. Wenn ein Flugzeug vorbeifliegt, muss der Ton sich an die Bewegung des Flugzeugs und des Menschen anpassen. So klingt der Sound glaubhaft. Auch der Hall muss möglichst realistisch nachgeahmt werden – im echten Leben prallen Schallwellen schließlich auf jede Menge Hindernisse und reagieren entsprechend, bevor sie die Ohren erreichen. Die Funktion dahinter schließt Frequenz, Materialabsorption, Raumgröße und Oberfläche mit ein.

Interaktion

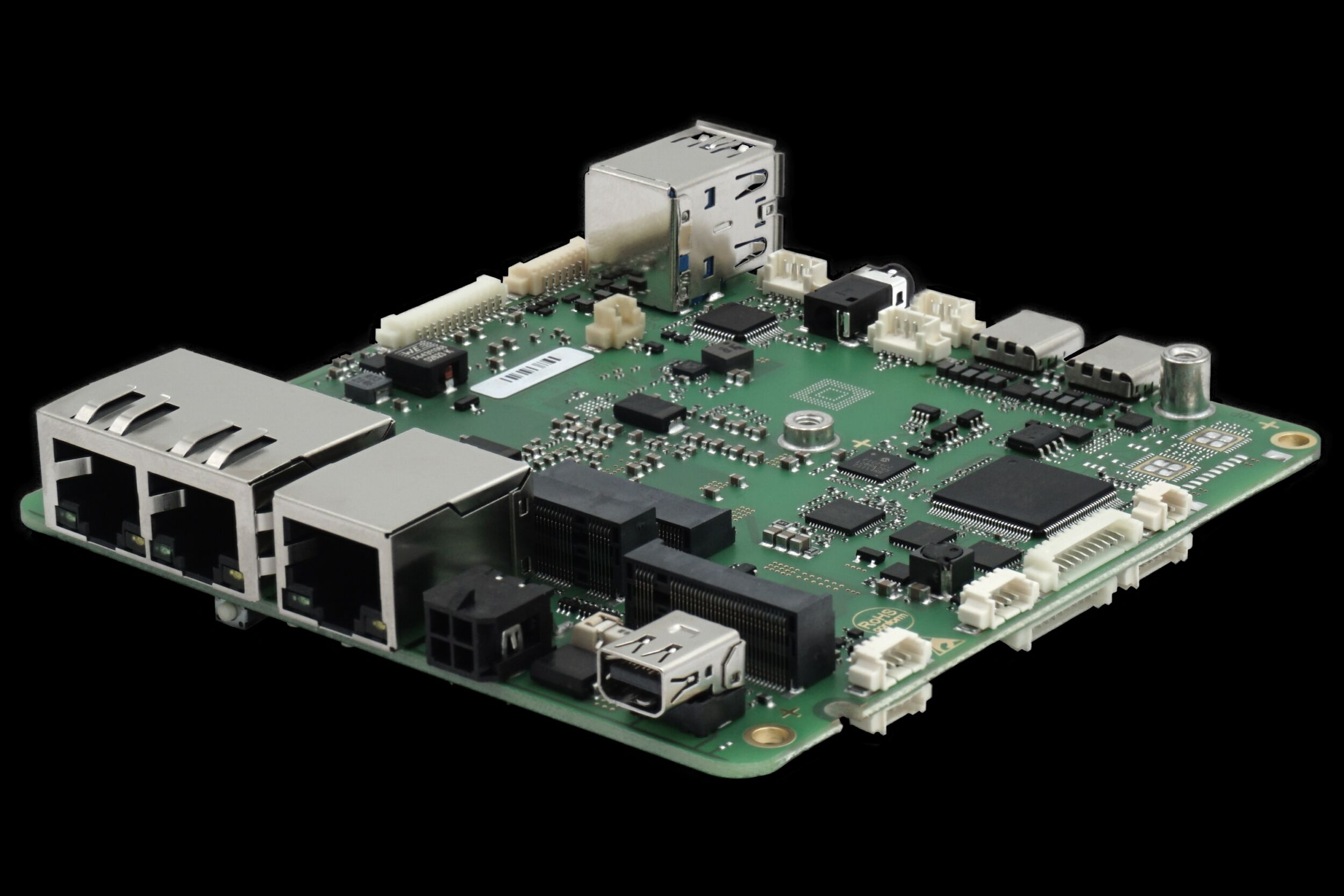

Die primäre Inputmethode eines VR-Headsets ist die Kopfbewegung. Dazu können Gesten, ein Controller oder auch Sprache genutzt werden. Dabei muss das Headset jedoch möglichst kabellos bleiben und weder am Strom noch am Computer hängen. Zu den extremen Rechenanforderungen und einer außerordentlich effizienten Leistung gesellen sich daher nicht nur die Gewichts- und Komfortanforderungen, sondern auch eine gute kabellose Vernetzung. VR bedeutet daher auch Wireless-Verbindungen mit hoher Bandbreite und geringer Latenz. Auch hier leiht sich VR wieder Entwicklungen aus der Mobiltechnologie: LTE Advanced, 802.11ac Wi-Fi und 802.11ad Wi-Fi erlauben schnelle Downloads und unterbrechungsfreies Streaming. Moderne LTE/Wi-Fi-Konvergenz rundet die Verbindungsfrage ab. Um VR in den engen Grenzen eines Headsets umsetzen zu können, bedarf es heterogenen Computings. Dabei sorgen spezialisierte Engines auf dem SoC für effiziente Verarbeitung und hohe Leistung bei wenig Verbrauch und geringer Wärmeentwicklung.

Das Problem mit der Latenz

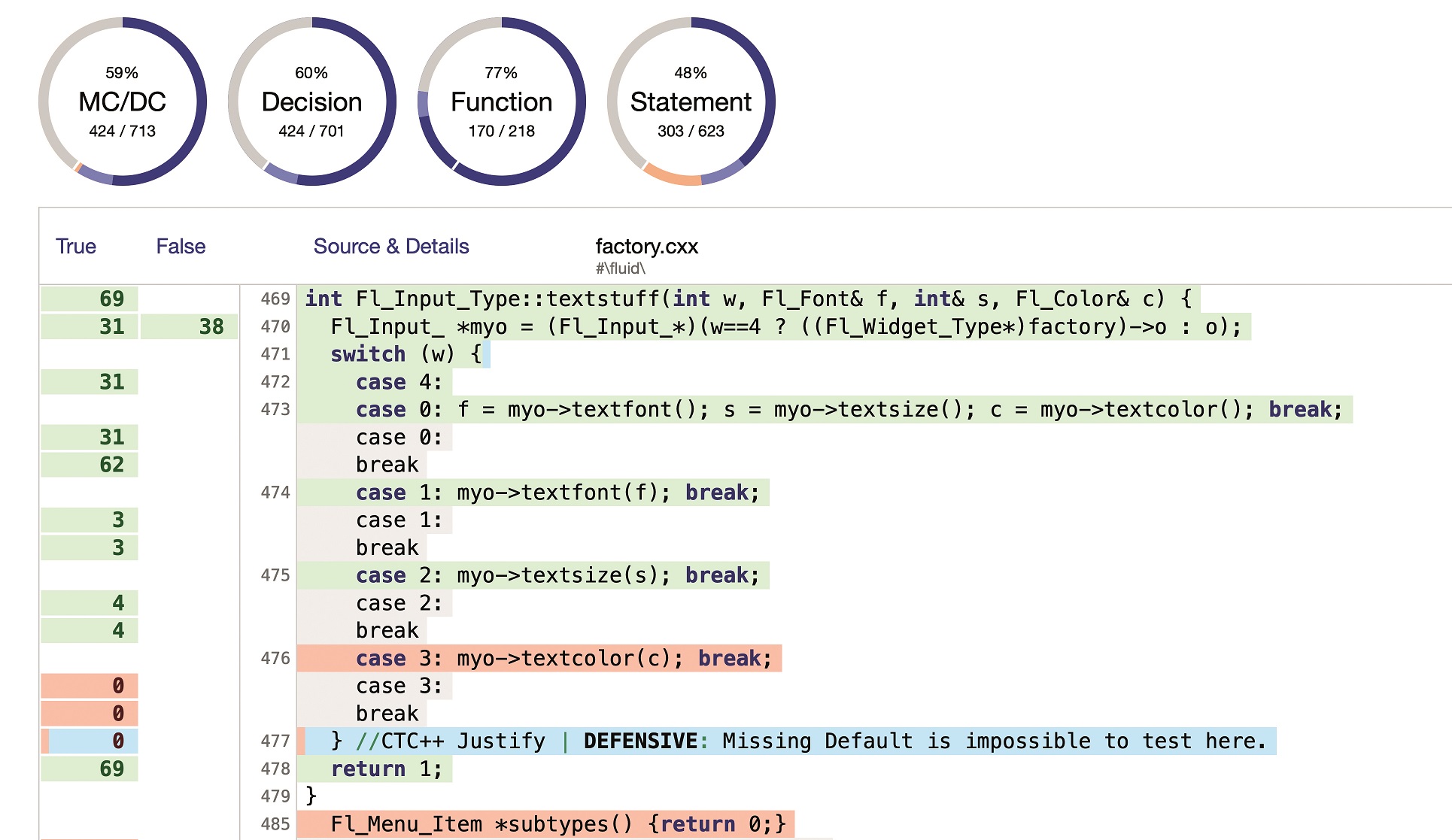

Jede Verzögerung im User Interface ist eine empfindliche Störung der Immersion – egal ob grafisch oder auditiv. Der Nutzer entwickelt bei VR-Headsets mit Latenz eine reale Übelkeit. Die Systemlatenz muss also so gering wie möglich gehalten werden, die virtuelle Welt muss auch in der Bewegung stabil bleiben. Die größte Herausforderung dabei: Die Zeit, die zwischen Inputbewegung und der Aktualisierung des Bildschirms vergeht. Hier spricht man auch von der Motion-to-Photon-Latenz. Die Aktualisierung des Bildschirms erfordert viele Rechenschritte – daher kann eine optimierte Latenz nur Ende-zu-Ende erfolgen. Dazu gehören Sensoren, Sensor-Fusion, Generierung, Rendern und Dekodierung, Bildkorrektur und Display-Update. Eine Ende-zu-Ende-Lösung muss drei Dinge zugleich leisten: die Latenz des einzelnen Tasks reduzieren, so viele Tasks wie möglich parallel laufen lassen und die richtigen Shortcuts bei der Berechnung nutzen. Alle Teile müssen harmonisch zusammenarbeiten – Hardware, Software, SoC, Sensoren und Display; alles muss zugleich optimiert werden. Eine immense Aufgabe.

Was ein SoC für VR leisten muss

Zu den Anforderungen eines modernen SoCs gehören eine Motion-to-Photon-Latenz von <18ms, sphärische 360°-Videos bei 4K und 60fps, sowohl für HEVC wie für VP9, 3D Positional Audio und LTE Advanced, 802.11ac und 802.11ad Wi-Fi. Doch Hardwareanforderungen alleine reichen nicht aus – auch das SDK muss Zugang zu neuen APIs bieten, etwa DSP Sensor-Fusion mit niedriglatentem, präzisem 6-DOF Motion Tracking in Echtzeit oder stereoskopem Rendering, das für das linke und rechte Auge Sichtfelder mit bis zu 3200×1800 Pixel bei 90fps leisten muss. Weitere Features, die momentan gefordert werden, sind Single Buffer Rendering – direktes Rendern in den Display-Buffer. All das sehen wir heute bereits in modernen SoCs, die aus dem Mobilbereich kommen. Wir leben am Anfang der massenhaften Verbreitung von VR, einer spannenden Zeit.

Autor: Hamid-Reza Nazeman, Managing Director Germany, Qualcomm

www.qualcomm.de