Test- und Messtechnik goes Embedded

Kein Zweifel, der Begriff ‚embedded‘ ist in nahezu allen Entwicklungsbereichen präsent. Und Entwickler arbeiten daran, dass immer mehr embedded wird, sowohl auf Chip-, als auch auf Boardniveau. Insbesondere die sehr hohe Innovationsrate bei Microcontrollern und FPGA erschließt eine völlig neue Welt von Möglichkeiten zur Schaffung intelligenter, vernetzbarer, rekonfigurierbarer und immer kompakter werdender Multifunktions-Elektronik. Neue Chip-Technologien im 3D-Bereich verstärken diesen Trend weiter, denn der Wunsch nach smarten Lösungen im Automobil, bei Consumerelektronik, in der Luft- und Raumfahrt oder der Industrieelektronik wächst.

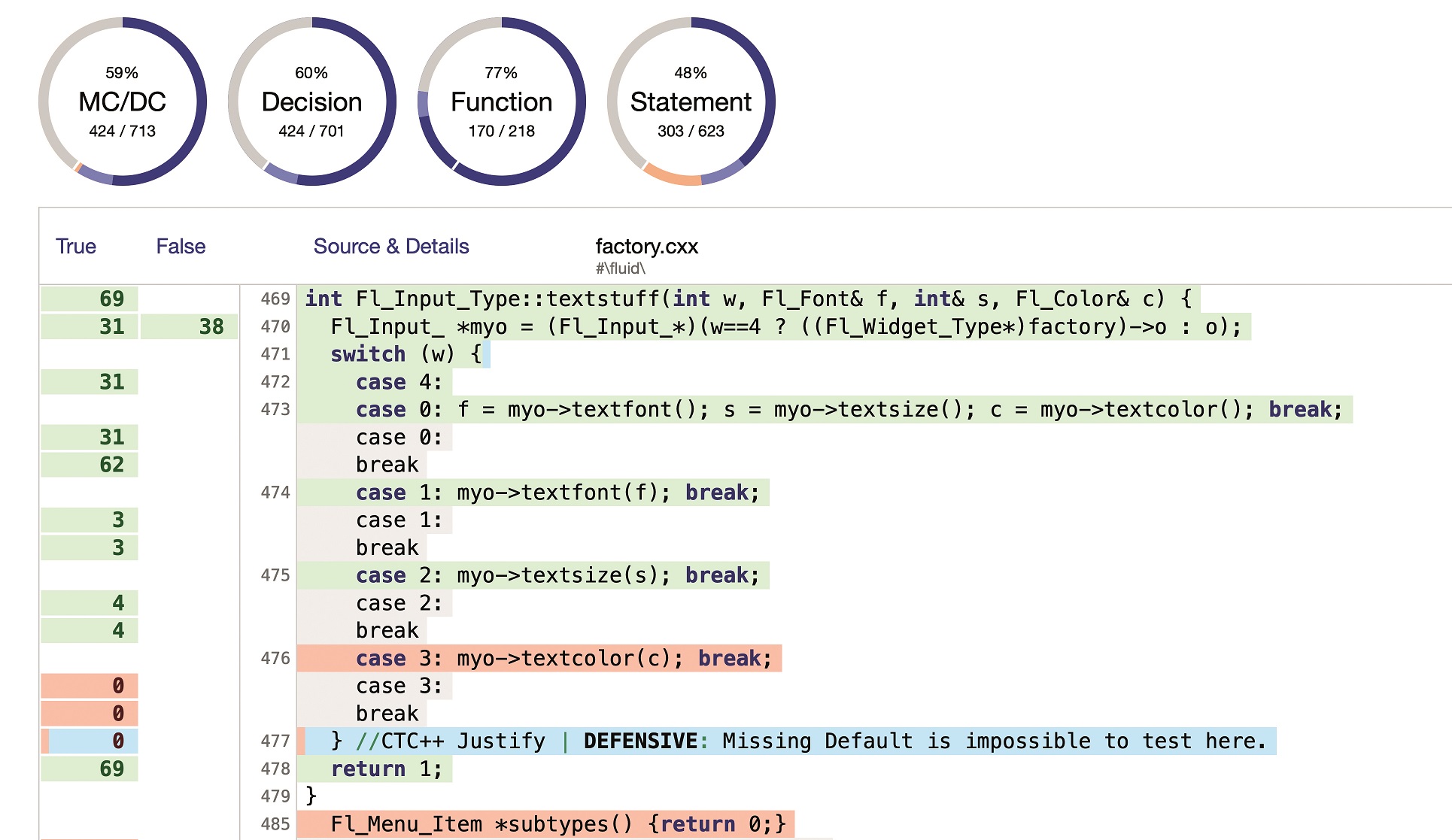

Die Entwicklung komplexer Produkte verlangt heutzutage nicht nur eine sehr gute Beherrschung von Software-, FPGA- und Board-Design, sondern auch eine exzellente Koordinierung der einzelnen Entwicklungsetappen von der Produktkonzeption, über das Design, die Implementierung und der kompletten Prototyp-Validierung. Eine wichtige Rolle hierbei spielt das sogenannte V-Modell. Es definiert für jeden Entwicklungsschritt adäquate Verifikationsprozeduren um schlussendlich eine strukturierte Gesamtvalidierung sicherzustellen. Dabei wurden im vorliegenden Modell die rein funktionalen Betrachtungen auch durch strukturelle Prozessschritte ergänzt. So sind strukturelle Validierungen und Tests, im Rahmen entsprechender Design for Testability-Strategien (DfT), mittlerweile fester Bestandteil moderner Entwicklungen und Produktionstests geworden und spielen dort eine zunehmend wichtigere Rolle. Entwicklern steht zur hierarchischen Validierung zudem ein immer breiter und performanter werdendes Spektrum an Instrumenten wie Emulatoren, Oszilloskopen, Logikanalysatoren und Bit Error Rate Tester (BERT) zur Verfügung.

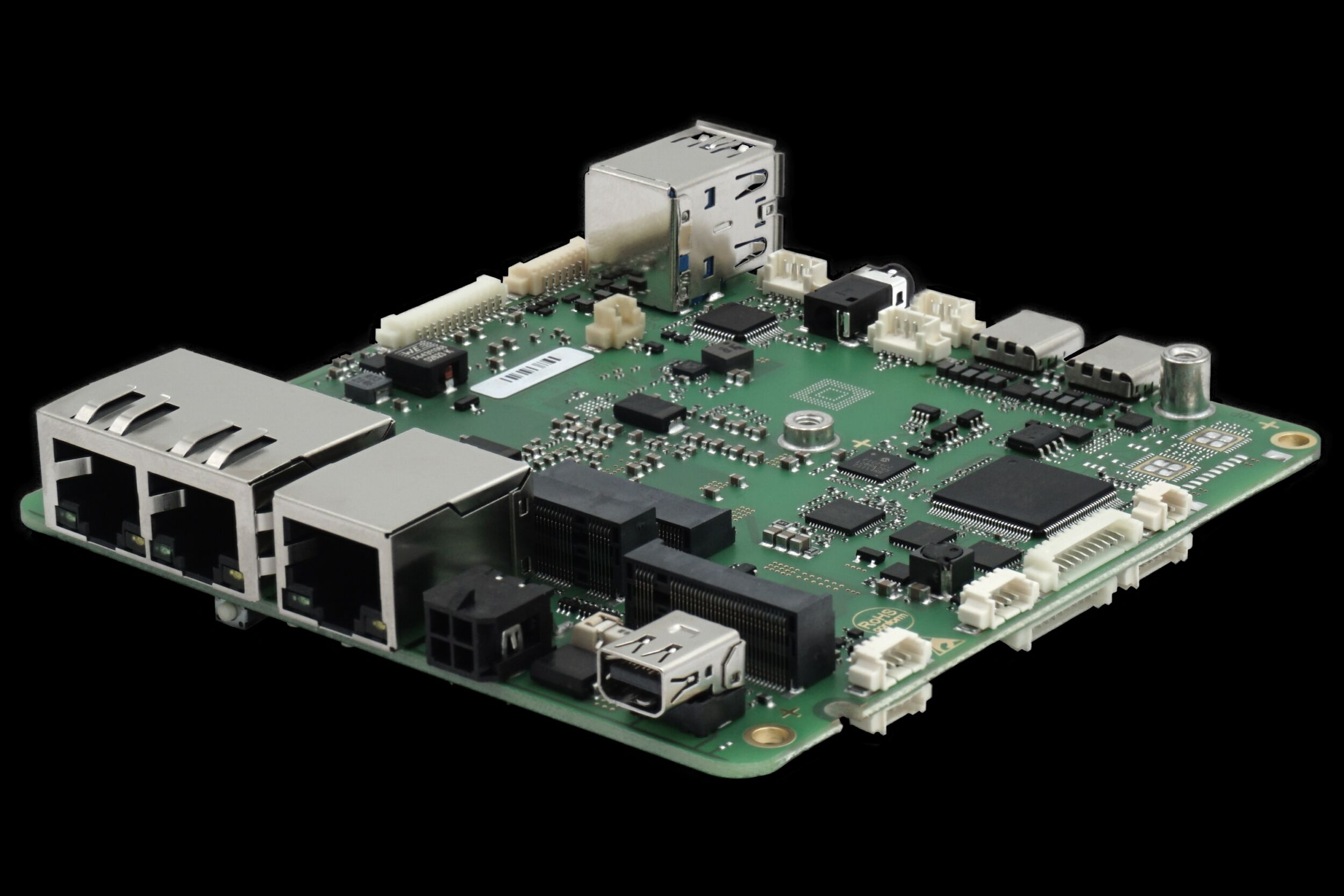

Herausforderung Signalgewinnung

Trotz der ausgeklügelten Testmodelle und -geräte berichten Entwicklungsingenieure und Testingenieure vor allem über Probleme der Signalgewinnung. War es früher möglich, fast jeden Pin oder wenigstens jedes Netz zur Verifikation bzw. zum Test zu kontaktieren, ist dies durch den immer weiter fortschreitenden Einsatz von Fine-Pitch IC, BGA und in der Leiterplatte eingebetteten Leiterzügen dramatisch erschwert. Dabei zeigt sich ein zunehmendes Missverhältnis von erforderlicher Testpunktgröße und schrumpfender Strukturgröße. Damit ist die klassische Strategie der In-Circuit Instrumentierung – also der taktile Einsatz von externen Instrumenten direkt in der Schaltung – für Entwickler nur noch in eingeschränktem Maße ein reales Hilfsmittel, um notwendige Signalinformationen zu erhalten. Der taktile Zugriff auf das zu verifizierende Objekt wird dadurch immer mehr auf die nativen Steckverbinder reduziert. Die gleiche Erfahrung machen aber auch die Testingenieure in der Produktion beim Einsatz des traditionellen In-Circuit Tests (ICT). Auch in diesem Bereich führt die geschilderte Entwicklung zu Problemen in Form verringerter Testabdeckung, stark steigenden Kosten zur Fehlerdiagnose bis hin zum No Failure Found-Syndrom (NFF). Entwickler reagieren auf diese Probleme unterschiedlich: Sie feilschen um jeden Testpunkt, setzten Flying Probe-Tester (FPT) ein, die auch sehr kleine Flächen bis hin zu Pin-Pads kontaktieren können, oder sehen einen verbesserten Funktionstest als Ausweg. Doch weder ICT noch Flying Prober können das Validierungsproblem lösen, und Testpunkte werden auch künftig immer weniger vorhanden sein. Doch Entwickler stehen nicht nur Problemen in der Validierung gegenüber. Neben dem Übergang zur Parallelverarbeitung durch Multicore-Systeme, steht dabei vor allem eine vergrößerte Signalübertragungsfrequenz im Visier der Entwickler. Um Informationen immer schneller zu übertragen und zu verarbeiten ist im Endeffekt auch eine kontinuierliche Geschwindigkeitssteigerung des internen Signalflusses unvermeidbar. Insbesondere der Übergang zu seriellen Gigabit-Links ist hier Thema Nummer eins. Solche Gigabit-Verbindungen werden extern über standardisierte Kommunikationsbusse wie beispielsweise USB3.0, PCI Express oder SATA-Express realisiert, sind aber auch board-intern als High Speed-Übertragungsmedium von Chip zu Chip zunehmend im Einsatz. Eine der wichtigsten Innovationstreiber sind an dieser Stelle FGPA. So bieten die neuesten FGPA-Generationen von Xilinx oder Altera Möglichkeiten bis zu 28Gbit/s und das parallel auf bis zu 96 Kanälen. Das Design-In solcher Gbit-Links verlangt allerdings größte Sorgfalt. So unterliegen solche Verbindungen aufgrund ihrer hohen Frequenzen mehr den typischen Merkmalen der Analogtechnik denn der Digitaltechnik, auch wenn die differentielle Übertragungstechnik eine Reihe von Problemen entschärft. In jedem Fall sind die Designregeln sehr stringent und erfordern impedanzoptimierte Implementierungen zur Erzielung höchster Übertragungsqualitäten. Zur Validierung derartiger Verbindungen stehen hochwertige Gigabit-Analyzer mit speziellen Tastköpfen zur Verfügung. Dennoch ruft die Antastung der GBit-Signale in jedem Fall eine Beeinflussung der Signalintegrität hervor. Moderne Gigabit-Analyzer versuchen diesem Problem durch Entzerrung beizukommen und kalkulieren den Einfluss der Probe ein. Die real verursachten Anomalien sind jedoch nur in der Wechselwirkung von elektrischen Eigenschaften des Probe-Targets und der Probe präzise analytisch berechenbar und bleiben daher im Verborgenen. Dabei ist die Höhe der Übertragungsfrequenz die entscheidende Größe und da diese immer weiter zunimmt sind auch die Anomalien immer größer, wodurch externe Instrumente an eine natürliche Grenze stoßen. Eine Betrachtung aus der Sicht des zu analysierenden Designs führt zu der Erkenntnis, das Entwickler und Tester nicht exakt erfahren, wie das Silizium reagiert. Und das erweist sich zunehmend als problematisch.

Wandel zum Embedded System Access

Eine Analyse der derzeit vorherrschenden Zugriffsstrategien offenbart eine Dreiteilung in die Klassen:

- • Native Connector Access (natürlicher Zugriff über die designintegrierten I/O)

- • Intrusive Board Access (künstlicher Zugriff über Nadeln und Proben)

- • Embedded System Access (natürlicher Zugriff über designintegrierten Testbus)

Dabei schließen sich diese Klassen in der praktischen Nutzung nicht gegenseitig aus, sondern können ergänzend genutzt werden. Im Licht der bisher beschriebenen Probleme ist vor allem der sogenannte Embedded System Access (ESA) eine wegweisende Technik. Die Wurzeln liegen hier bereits über 20 Jahre zurück und haben ihren Ursprung im sogenannten Boundary Scan Verfahren, das im Jahr 1990 als IEEE1149.1 normiert wurde. Durch evolutionäre Entwicklungen umfasst ESA heute eine Vielzahl von nicht-intrusiven Technologien zum Validieren, Testen, Debuggen und Programmieren. Dazu zählen insbesondere Boundary Scan Test (IEEE1149. 1/4/6/7), Processor Emulation Test (PET) und Chip Embedded Instrumentation (IJTAG/IEEEP1687). Als Kerngedanke folgt ESA der Idee, den taktilen Zugriff durch einen im Silizium integrierten Zugriff zu ersetzen. Dabei verfügt jede ESA-Technologie im Prinzip über eine aufgabenspezifische Pin-Elektronik, die über einen Testbus angesteuert wird und somit in der Lage ist Testfunktionen oder Programmierungen direkt im System auszuführen. Das Zielsystem kann dabei ein Chip, ein Board, oder eine ganze Unit sein, ist also invariant gegenüber dem hierarchischen Applikationslevel. Dadurch lässt sich der Embedded System Access prinzipiell beim V-Modell und im gesamten Produktlebenszyklus verwenden.