HDR- Sensoren in der Praxis

Um ein Vielfaches mehr Dynamik

Wechselnde und inkonsistente Lichtverhältnisse sind für zahlreiche Anwendungsbereiche in der industriellen Bildverarbeitung eine echte Herausforderung. Insbesondere wenn Detailinformationen eines Bildes benötigt werden und die Detailschärfe auf Grund von Belichtungsproblemen nicht erfassbar ist. Können HDR-Sensoren hier Abhilfe schaffen?

Zu diesen Anwendungsbereichen zählt beispielsweise die Schweißtechnik, deren Lichtbogen so extrem hell ist, dass eine Kamera die geschweißte Naht nicht mehr erkennen kann. Bei Verkehrsüberwachungen, bei denen ein Blitz eingesetzt wird, sind häufig Nummernschilder auf Grund reflektierender Eigenschaften nicht mehr lesbar. In der Sicherheitstechnik sind besonders Aufnahmen bei Sonnenlicht kritisch, da hier z.B. in spiegelnden Scheiben Informationen nicht mehr erfasst werden können. Im Bereich Fahrassistenzsysteme werden ebenfalls hohe Anforderungen gestellt, um bewegte Hindernisse im Gegenlicht oder in Blendsituationen zu erkennen.

HDR, LDR und Dynamikumfang

Die Abkürzung HDR steht für High Dynamic Range und bezeichnet das Aufnehmen oder Erzeugen von digitalen Bildern mit hohem Dynamikumfang. Bildaufnahmen mit herkömmlichen Verfahren werden im Gegensatz mit LDR (Low Dynamic Range) bezeichnet. Der Dynamikumfang ist dabei der größte, im gesamten Bild vorkommende Kontrast und kann daher auch als Kontrastverhältnis bezeichnet werden (das Verhältnis des größten Helligkeitswerts zum geringsten Helligkeitswert). Ein Motiv besitzt demnach einen hohen Dynamikumfang, wenn innerhalb einer Szene zur gleichen Zeit sehr helle und sehr dunkle Bereiche vorhanden sind. Hierzu gehört zum Beispiel die Aufnahme einer Person, die mit dem Rücken zur Sonne steht. Davon abgesehen kann ein Motiv jedoch auch sehr große Helligkeit bei geringem Dynamikumfang besitzen, weil keine dunklen Bereich enthalten sind, wie zum Beispiel bei einem direkten Blick in die Sonne. Dynamikbereiche werden üblicherweise in der logarithmischen Einheit dB (Dezibel) angegeben. Der Wert in dB drückt dabei aus, um welchen Faktor der höchste Helligkeitswert größer ist als der geringste Helligkeitswert. Ein typischer Bildsensor mit einem Dynamikbereich von 60dB könnte also eine Motivdynamik von 1000:1 abbilden, d.h. der höchste Helligkeitswert ist 1000 mal so hell wie der geringste Helligkeitswert. Das menschliche Auge kann einen Dynamikumfang von bis zu 100dB innerhalb einer Szene wahrnehmen, was einem Helligkeitsverhältnis von 100.000:1 entspricht.

Lineare Funktionsweise

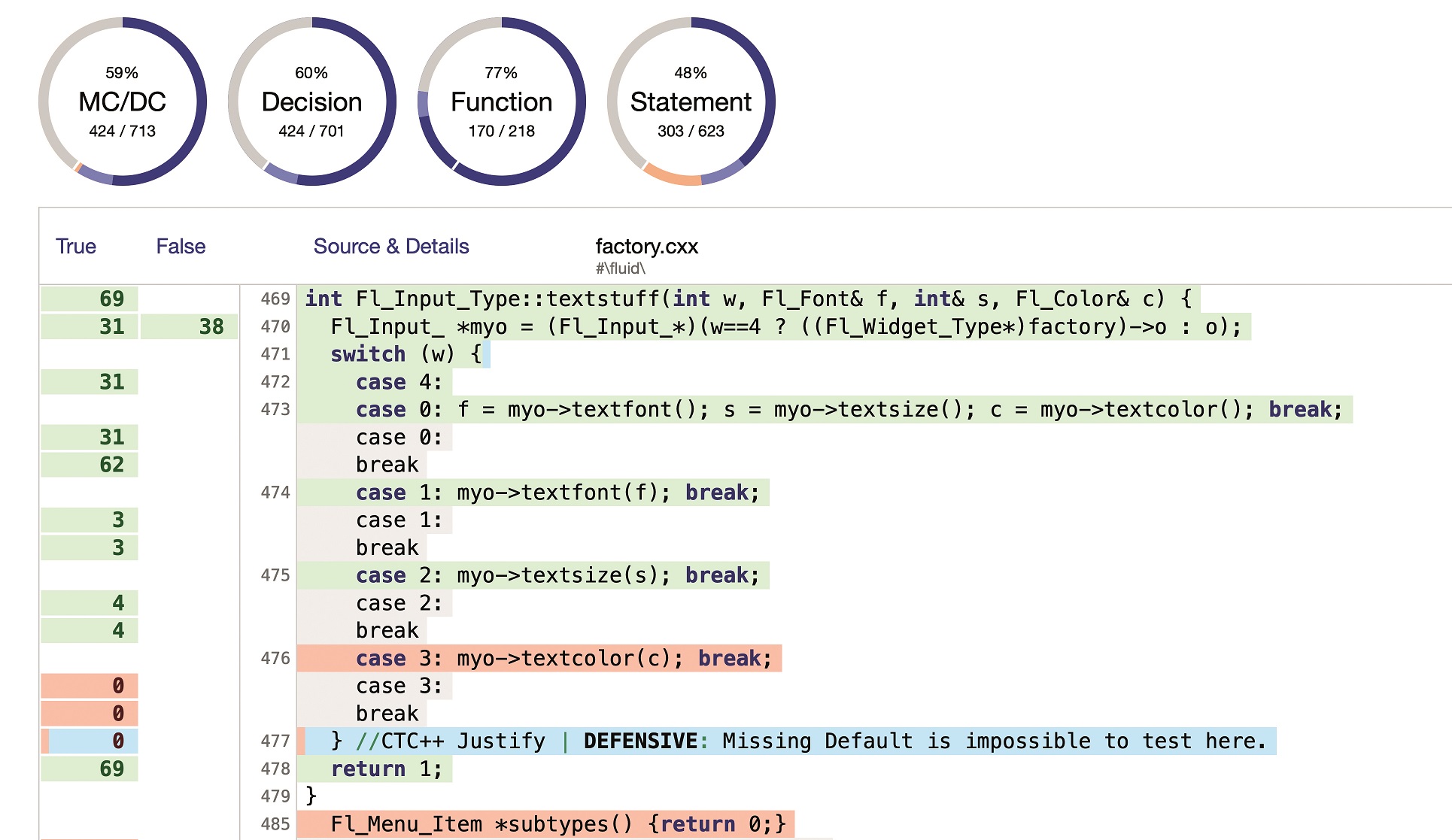

Die Pixel eines herkömmlichen CCD- oder CMOS-Sensors erzeugen elektrische Ladung proportional zur einfallenden Lichtmenge. Für die Dauer der Belichtungszeit werden die Ladungsträger gesammelt und am Ende der Belichtungszeit wird für jeden Pixel ausgelesen, wie viel Ladung vorhanden ist. Der Dynamikbereich eines solchen Sensors wird nach oben durch die Sättigung der Pixel begrenzt. Die Grafik in Abb.1 zeigt anhand der Kennlinie, dass ein herkömmlicher linearer Sensor nur einen recht begrenzten Dynamikbereich des Motivs abbilden kann. Die restlichen Bereiche können auf Grund der Sättigung nicht abgebildet werden. Wenn bei einem Sensor die Sättigung erreicht ist, führt weiterer Lichteinfall zur Überbelichtung. Bei CCD-Sensoren tritt außerdem der sogenannte Blooming-Effekt auf: Ladungsträger aus überbelichteten Pixeln fließen in die Nachbarpixel, so dass ganze Bereiche im Bild weiß erscheinen, die Bildinformationen sind damit verloren. Um die Überbelichtung zu verhindern, kann die Blende geschlossen oder die Belichtungszeit reduziert werden. Beides führt jedoch dazu, dass dunkle Bildbereiche nur noch Rauschen enthalten, die Bildinformation ist in diesem Fall ebenso verloren (Abb. 2). Um Bildaufnahmen von Szenen mit einem hohen Dynamikumfang zu ermöglichen, wurde beispielsweise mit sogenannten Belichtungsreihen gearbeitet. Hier wird eine Folge aus mehreren verschieden belichteten Einzelaufnahmen (korrekte Belichtung, Unterbelichtung, Überbelichtung) desselben Bildausschnitts erzeugt, die später verrechnet werden. Diese Methode funktioniert jedoch nur bei statischen Objekten und gleichbleibenden Hintergrund. Denn ein bewegtes Objekt ändert im Laufe einer Belichtungsreihe seine Position und führt bei der Verrechnung der Einzelbilder zu Bildfehlern.

Logarithmisch versus linear

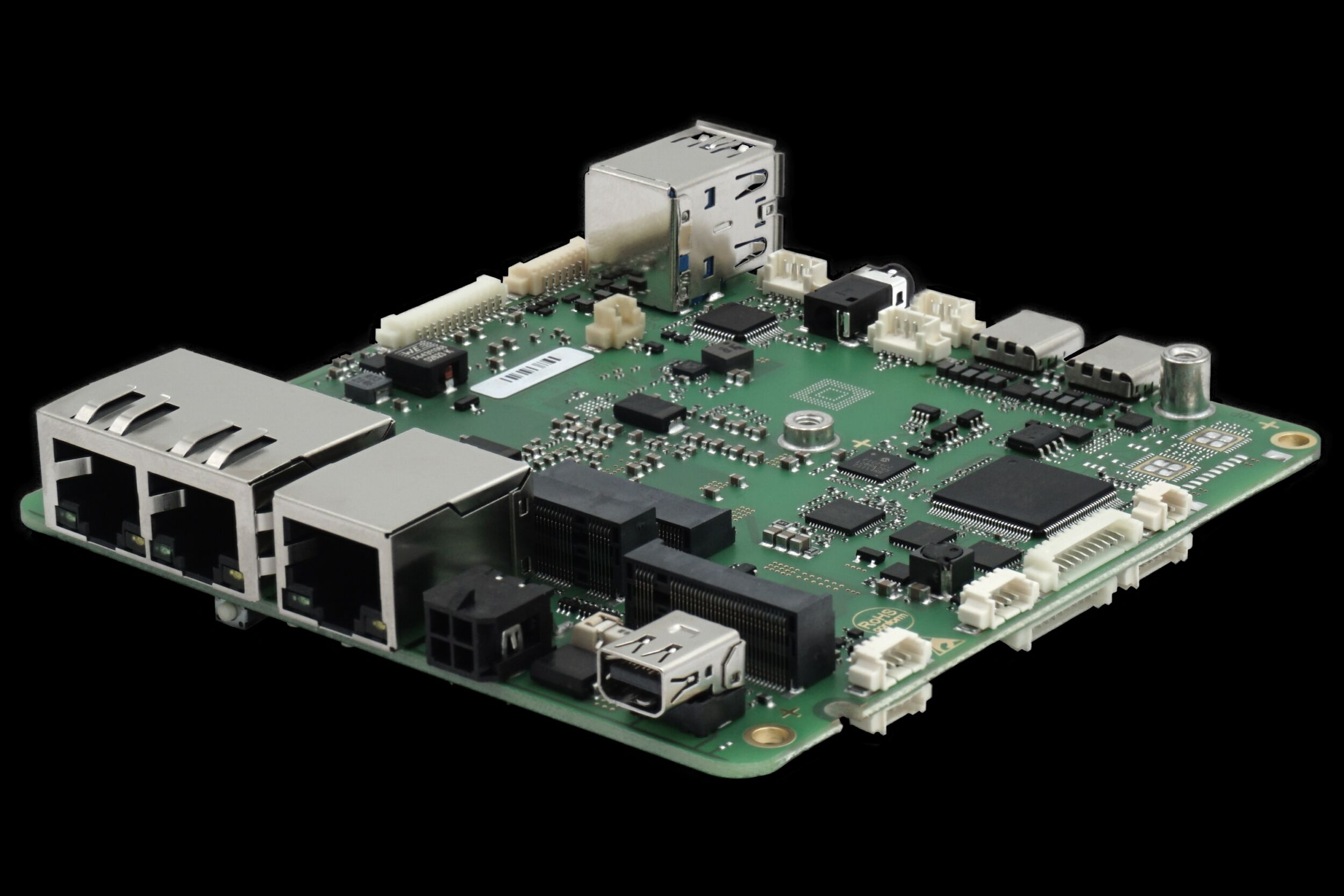

Das menschliche Auge hingegen nimmt Helligkeitsunterschiede komprimiert wahr. Grundlage für die Fähigkeit bei Sonnenlicht auch Schatten zu erkennen, bildet die logarithmische Kennlinie, da nur hier keine Übersteuerung stattfindet. Helligkeitsunterschiede werden mit zunehmendem Wert stärker komprimiert (siehe Abb. 3). Ein herkömmlicher, linearer Sensor ist mit dieser Bilddynamik überfordert. Um mit einem Sensor mit linearer Kennlinie einen Dynamikumfang von 120dB aufnehmen zu können, wären nach dem Sensor 1 Million Digitalstufen und demnach eine Bittiefe von 20Bit erforderlich. Wenn allerdings der Sensor eine logarithmische Kennlinie ähnlich der des Auges besitzt, lässt sich der Dynamikumfang des Motivs von 120dB mit einer geringeren Anzahl digitaler Stufen abbilden. Es findet eine Dynamikkompression im Pixel statt. Aus diesem Grund wird für HDR-Sensoren eine logarithmische Kennlinie angestrebt. Der HDR-Sensor, den IDS in den Kameras der uEye Serie verwendet, erzeugt eine solche logarithmi-sche Kennlinie. In diesem Sensor kommen allerdings keine herkömmlichen Fotodioden zum Einsatz, sondern miniaturisierte Solarzellen. Dies sind prinzipiell ebenfalls Fotodioden, die allerdings anders betrieben werden. Während Fotodioden einen linearen Strom proportional zur Lichtmenge erzeugen, geben Solarzellen eine logarithmische Spannung in Abhängigkeit von der Lichtmenge aus. Das bedeutet, dass keine nachträgliche Logarithmierung des Signals erforderlich ist die Kennlinie ist bereits echt logarithmisch. Der Sensor erreicht dabei einen Dynamikumfang von 120dB. Damit gehen selbst bei extrem kontrastreichen Bildern keine Informationen mehr durch Überstrahlung verloren (siehe Abb. 4). Bei uEye GigE-Kameras mit HDR-Sensor können die Bilddaten mit voller Bittiefe von 12Bit ausgelesen werden. Somit können durch nachträgliche Kontrastanpassung sehr viele Details und Helligkeitsstufen des Originalbildes sichtbar gemacht und für die Bildauswertung verwendet werden (siehe Abb. 5).

Ausblick

Die momentan erhältliche Sensorvariante bietet PAL-Auflösung. Aktuell arbeitet IDS an einer weiteren Kamera mit einem 2/3″ Sensor und 1,3 Megapixeln. Das Thema Farbe ist etwas komplexer und erfordert mehr Rechenaufwand, um mittels tone-mapping adäquate Farbbilder zu erzeugen. Hochauflösende Farbsensoren sind angekündigt, denn Farbe in der Bildverarbeitung ermöglicht eine signifikant verbesserte Klassifizierung für alle vorgenannten Einsatzgebiete in der Verkehrsüberwachung und der Sicherheitstechnik als auch für Industrieanwendungen. Da außerdem die Anforderungen in der Qualitätssicherung konstant steigen, sind Megapixel-Auflösungen auch im HDR-Bereich nötig.