Machine Learning in Embedded Systemen implementieren

In diesem Jahr steht für Mathworks auf der embedded world (Halle 4, Stand 110) das Thema Implementierung von Algorithmen des Machine Learning und Deep Learning in Embedded Systemen im Fokus. MathWorks zeigt mehrere Beispiele aus verschiedenen Anwendungsbereichen des maschinellen Lernens, wie die Erkennung und Klassifizierung von Objekten und Sprache für autonome Systeme.

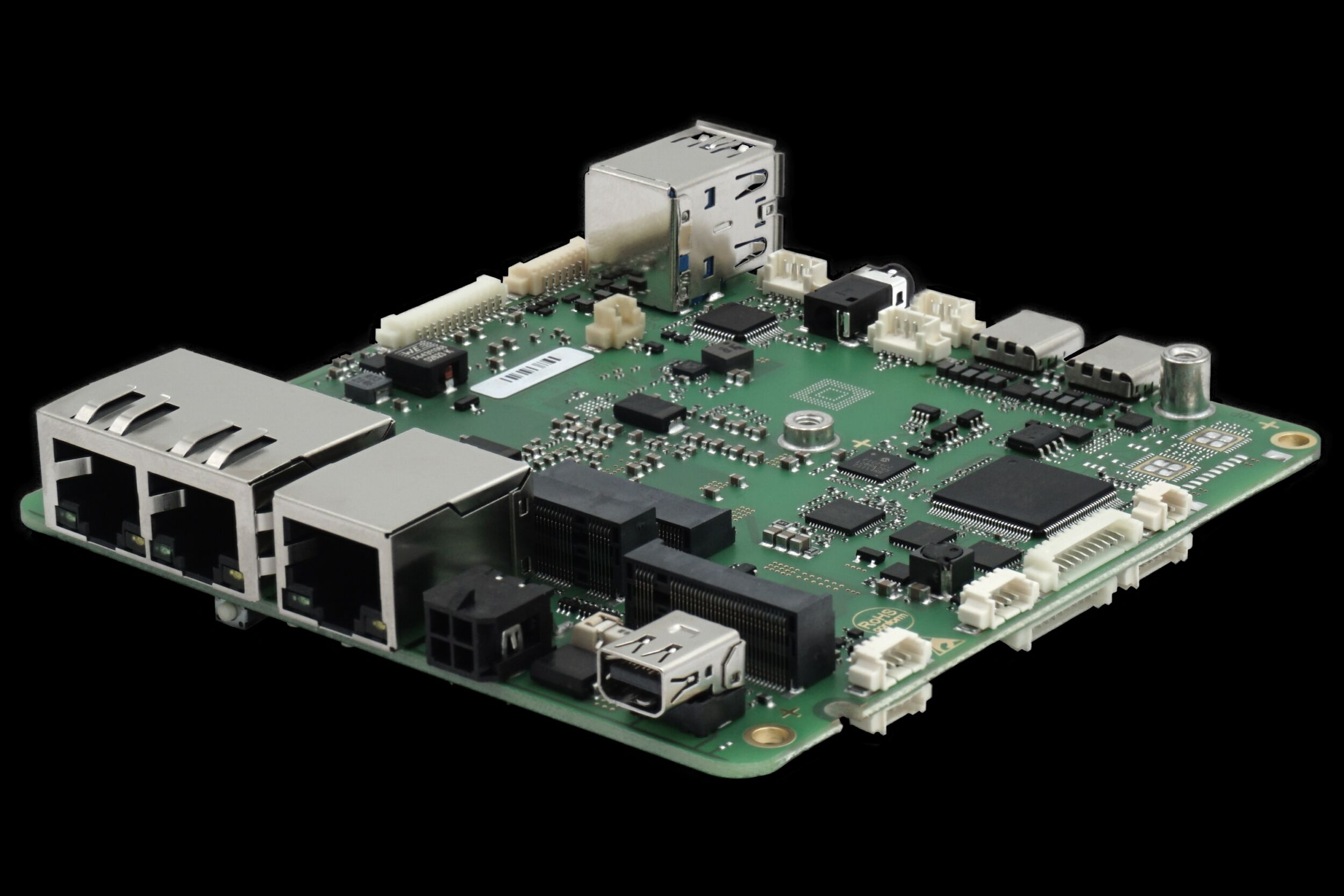

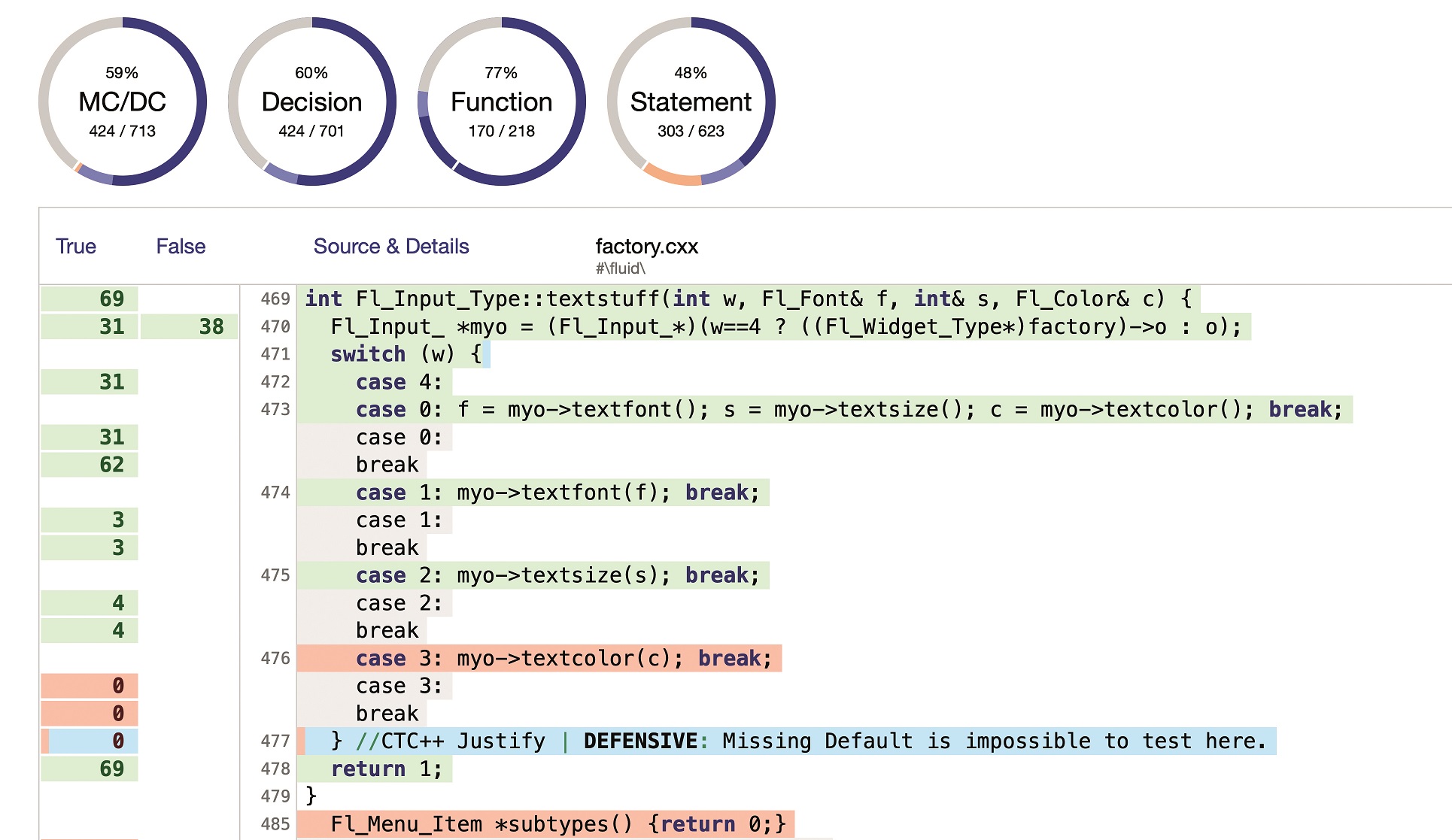

Machine Learning und Deep Learning sind leistungsstarke Methoden, um komplexe Modellierungsaufgaben in den verschiedensten Industriebereichen zu lösen. Das Kernprinzip besteht darin, dass Ingenieure und Wissenschaftler Modelle entwickeln, die selbstständig aus Daten lernen. Auf diese Weise können zum Beispiel Maschinenausfälle durch vorausschauende Wartung vorhergesagt und entsprechend vermieden werden oder Fahrzeuge mittels autonomer Systeme selbstständig lenken. Doch wie kommt die Intelligenz in die Maschine? Um Algorithmen des Machine Learning produktiv nutzen zu können, eignet sich die Implementierung in Embedded Systemen oder in einer Cloud-Infrastruktur. Dabei zeigen sich je nach Modell unterschiedliche Präferenzen für die genutzte Hardware. So werden für Machine-Learning-Verfahren wie etwa ‚Support Vector Machine‘ vor allem Microcontroller genutzt, während sich für die Implementierung von Convolutional Neural Networks (CNN) im Bereich des Deep Learning GPUs etabliert haben. In beiden Fällen muss das entwickelte Modell in weniger abstrakten Code, zum Beispiel in C, umgewandelt werden, um auf die Hardware überführt werden zu können. Der MathWorks GPU Coder wurde speziell dafür entwickelt, immer intelligenter werdende Matlab-Anwendungen und Deep Learning Netze auf GPUs zu integrieren. Dabei werden die Matlab-Modelle in optimierten NVIDIA CUDA Code umgewandelt. So können auch rechenintensive Teile des Matlab Codes schneller ausgeführt werden. Änderungen im Matlab-Code können durch Knopfdruck auf den CUDA-Code übertragen werden, was zudem die Synchronisierung zwischen beiden Modellen vereinfacht.