FPGA Beschleunigerkarten

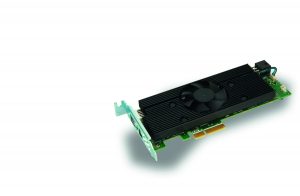

Stehen Anforderungen an kurze Latenzzeiten im Raum, oder sind höhere Auflösungen bei einer höheren Taktrate zu verarbeiten, bietet sich die Mustang-F100 an. Anders als die Mustang-V100 Serie basiert die Mustang-F100 auf dem Intel Arria 10 GX1150 FPGA und ist mit 8GB on-board DDR4 RAM ausgestattet. Ihr kompaktes Profil (170x68x34mm) und standardisiertes PCIe Gen3 x8 Interface sorgen für eine problemlose Integration der KI-Beschleunigerkarte. Das Zuweisen einer individuellen Karten-ID ermöglicht den flexiblen Betrieb von mehreren F100 innerhalb eines einzelnen Inferenzsystems. Durch die Parallelität der Datenverarbeitung und dem hohen Konfigurierungsgrad, die dem FPGA zu eigen sind, kann die Mustang wechselnde Workloads und verschiedene Gleitkommazahlen verarbeiten. Dank integrierter Intel Enpirion Power Lösung weist die Karte eine hohe Effizienz (<60W TDP), Leistungsdichte und Performance (bis zu 1,5 TFLOPs) auf.

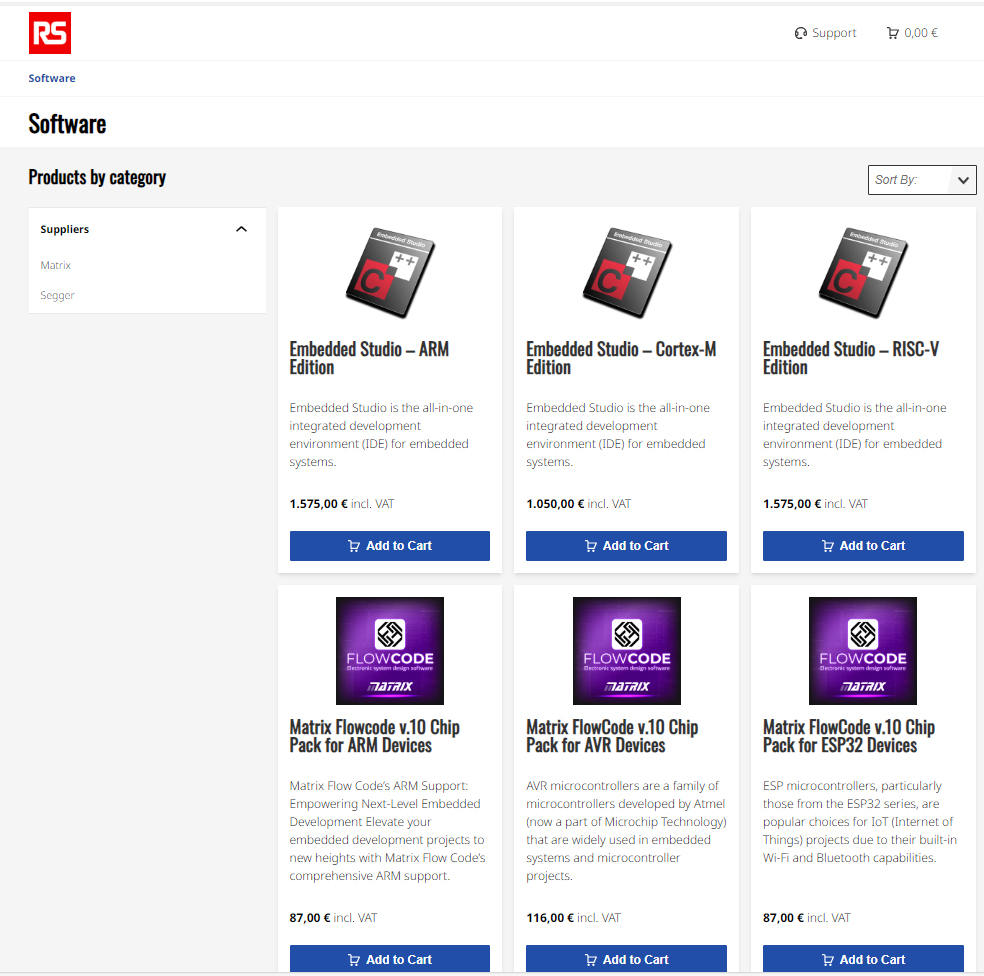

Softwareunterstützung

Sowohl für die Serie mit VPU als auch mit FPGA stehen Software Development Kits von Intel zur Verfügung. Mit dem Intel Movidius Myriad Development Kit (MDK) können eigene Funktionen eingebunden und beliebige Verarbeitungspipelines aufgebaut werden. Es steht ein reichhaltiges Angebot an Bibliotheken für Vision, Bildverarbeitung und Neurale Netze zur Auswahl. Für die Serie mit FPGA bietet Intel Entwicklern das FPGA SDK for OpenCL, eine Entwicklungsumgebung die einfach auf FPGAs zu implementieren ist, den Platform Designer und den DSP Builder für FPGAs. Die Mustang Serien V100 und F100 bieten Entwicklern zusätzlich, mit der Kompatibilität zum OpenVino Toolkit, eine optimierte Integration von Trainingsmodellen ohne aufwändiges Trail and Error. Zusätzlich wird auch die Leistung der Mustang-F100 oder V100 durch die Kompatibilität mit dem Intel OpenVino Toolkit optimiert. Das Toolkit nimmt automatisch eine passende Skalierung auf das jeweilige Zielsystem an der Edge vor. Darüber hinaus wird bereits eine Vielzahl von Topologien wie z.B. AlexNet, GoogleNet V1/V2/V4, Yolo Tiny V1/V2, Yolo V2/V3, SSD300, SSD512, ResNet-18/50/101/152, DenseNet121/161/169/ 201, SqueezeNet 1.0/1.1, VGG16/19, MobileNet-SSD, Inception-ResNetv2, Inception-V1/V2/V3/V4, SSD-MobileNet-V2-coco, MobileNet-V1-0.25-128, MobileNet-V1-0.50-160, MobileNet-V1-1.0-224, MobileNet-V1/V2 und Faster-RCNN unterstützt. Von der klassischen Objekterkennung über die Video- und Bildklassifikation bis hin zur Gesichtserkennung oder Bildsegmentierung sind anwendungsseitig kaum Grenzen gesetzt.

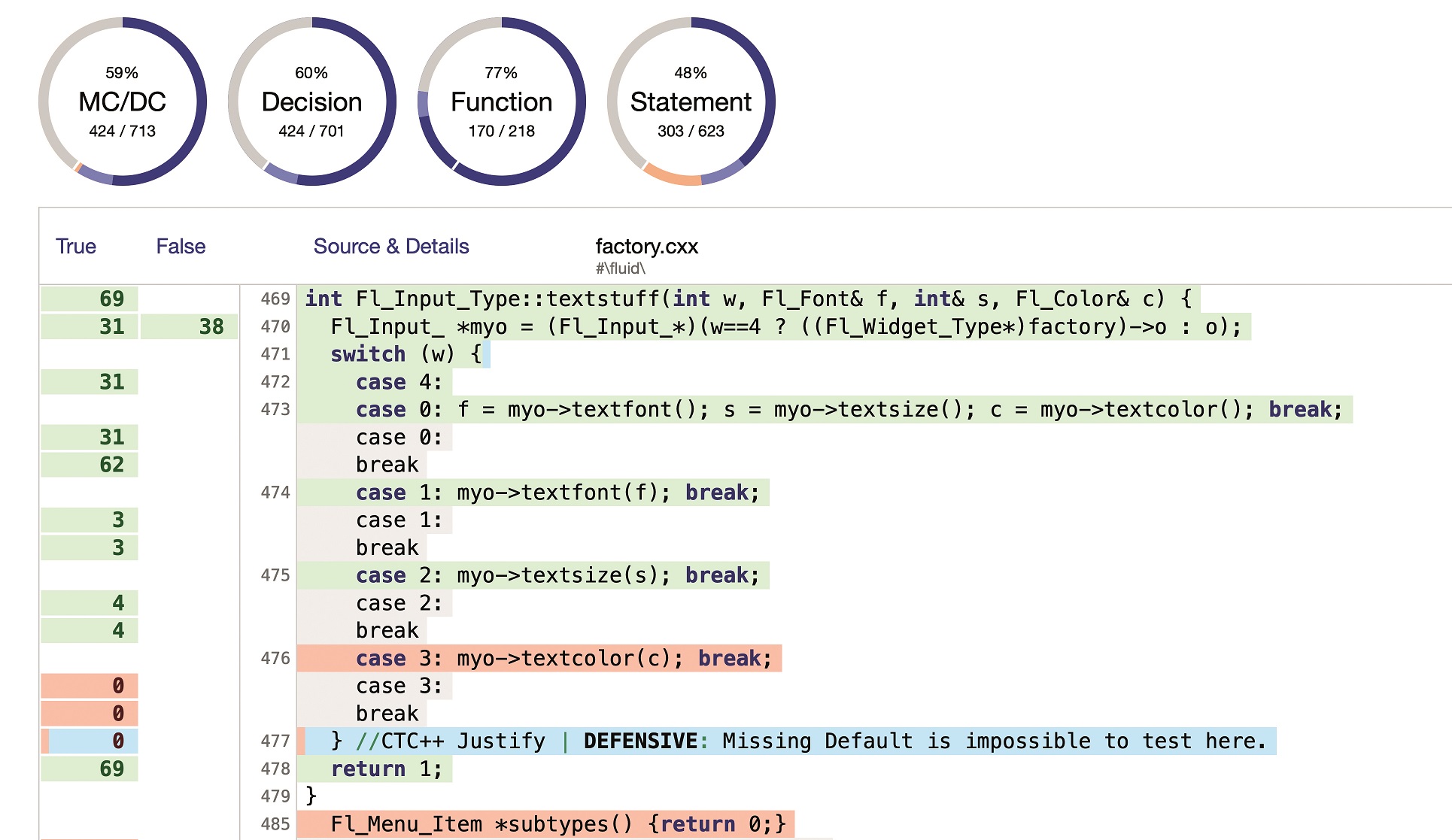

Benchmark

Je nach Topologie empfiehlt es sich den Bitstream der Mustang-F100 anzupassen, um ihre Performance bestmöglich zu optimieren. Je nach OpenVino Toolkit Version stehen unterschiedliche Bitstreams zur Verfügung, die mit dem Toolkit eingespielt werden. Benchmark Tests mit dem im OpenVino Toolkit integrierten Testtool zeigen, dass man durch die Anpassung des Bitstreams an die verwendete Topologie GPU-basierten Inferenzmaschinen deutlich den Rang ablaufen kann. Z.B. zeigt die Mustang-F100 eine 87 Prozent höhere Performance bei SqueezeNet 1.1 oder 82 Prozent bei Yolo Tiny V1 gegenüber einer Nvidia P4 Lösung. Ein kompetenter Partner unterstützt Kunden beim Bitstreamwechsel und erstellt auf Wunsch kundenspezifisch angepasste Bitstreams.

Fazit

Die Mustang Serie ist mit ihrer Low-Power-Architektur und ihrer Skalierbarkeit eine gute Alternative zu GPU-basierten KI Lösungen. Inferenzmaschinen erhalten durch Verwendung von KI Beschleunigerkarten eine deutliche Performancesteigerung. Mit OpenVino Toolkit können Entwickler Trainingsmodelle ohne aufwändige Trial and Error an der Edge zu implementieren.